豆包是否可以本地部署 自主可控环境下运行豆包的技术路径说明

本文旨在解答关于豆包是否可以在本地环境下进行部署并实现自主可控运行的问题。目前,豆包主要以

本文旨在解答关于豆包是否可以在本地环境下进行部署并实现自主可控运行的问题。目前,豆包主要以云服务形式提供,用户通过网络访问其功能。要在自主可控的环境下运行类似的大型语言模型能力,通常需要采用不同的技术路径,即在本地计算资源上部署可用的AI模型。本文将概述实现本地自主可控AI运行的通用技术路线和关键步骤,帮助理解其过程。

理解豆包的运行模式

豆包是基于大型语言模型的智能服务,其核心模型和计算资源部署在服务提供商的云端基础设施中。用户通过客户端或接口与云端服务进行通信和交互。这意味着,豆包的日常运行和技术控制權主要掌握在服务提供方。

实现自主可控本地AI的技术路径

要达到在自主可控环境下运行类似大型语言模型的能力,其技术路径不同于直接“安装”云服务。这通常涉及在拥有完全控制权的本地硬件上,部署并运行适配本地环境的AI模型。以下是实现这一目标的通用技术步骤说明:

1、硬件资源准备:部署大型AI模型要求具备强大的本地计算能力,尤其是高性能的图形处理器(GPU)。GPU的显存容量是决定可加载模型规模和运行效率的关键要素。建议根据计划运行的模型大小选择合适的显卡。

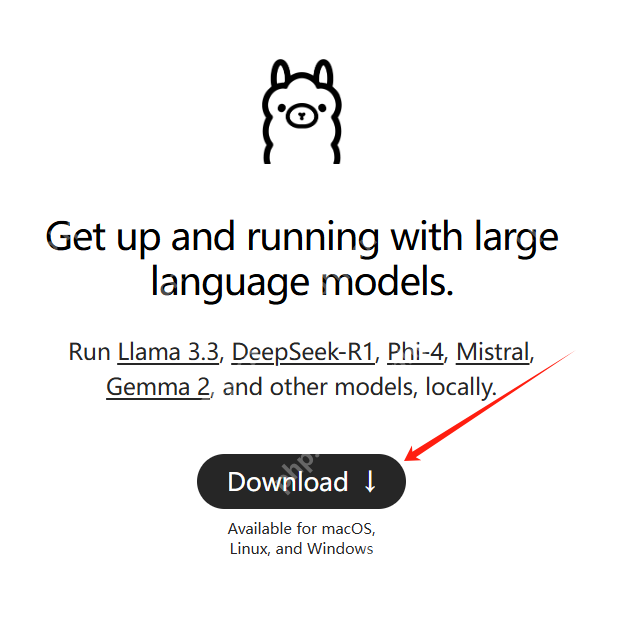

2、软件环境配置:需要在本地操作系统上安装必要的软件栈,包括兼容的显卡驱动程序、用于模型推理的框架(如TensorFlow、PyTorch)或专门优化的本地推理引擎(例如针对消费者硬件的llama.cpp、Ollama等)。

立即进入“豆包AI人工智官网入口”;

立即学习“豆包AI人工智能在线问答入口”;

3、模型获取与选择:选择并获取适合本地部署的大型语言模型文件。目前社区提供了许多开源或允许本地使用的预训练模型,这些模型通常有不同的大小和量化版本,以适应不同的硬件能力。

4、模型加载与设置:使用选定的推理引擎或框架加载下载到本地的模型文件。在此过程中,通常需要进行一些配置,例如指定模型文件的路径、选择合适的量化精度以优化显存占用和推理速度。

5、模型执行与集成:启动推理过程,通过编程接口或命令行与本地加载的模型进行交互。可以根据具体需求,将模型能力集成到本地应用程序、自动化脚本或工作流程中,实现自主调用和控制。

本地自主可控运行的考量

在本地实现AI的自主可控运行,不仅是技术部署问题,还需要考虑数据隐私、系统安全、以及持续的资源消耗(如电力、散热)和维护成本。确保本地数据不外泄,运行环境不受外部干扰,是实现真正自主可控的关键环节。

菜鸟下载发布此文仅为传递信息,不代表菜鸟下载认同其观点或证实其描述。

相关文章

更多>>热门游戏

更多>>热点资讯

更多>>热门排行

更多>>- 猪猪公寓排行榜下载大全-2023最好玩的猪猪公寓前十名推荐

- 核心神器ios手游排行榜-核心神器手游大全-有什么类似核心神器的手游

- 魔月永恒游戏排行-魔月永恒所有版本-魔月永恒游戏合集

- 2023秘境神塔手游排行榜-秘境神塔手游2023排行榜前十名下载

- 类似剑来天下的游戏排行榜_有哪些类似剑来天下的游戏

- 永恒之塔最新排行榜-永恒之塔手游免费版下载-永恒之塔免费破解版下载

- 奇迹muios手游排行榜-奇迹mu手游大全-有什么类似奇迹mu的手游

- 冰雪斩龙最新排行榜-冰雪斩龙手游免费版下载-冰雪斩龙免费破解版下载

- 仙侠风云游戏排行-仙侠风云所有版本-仙侠风云游戏合集

- 热血之光手游2023排行榜前十名下载_好玩的热血之光手游大全

- 多种热门耐玩的绝园少女破解版游戏下载排行榜-绝园少女破解版下载大全

- 极上红颜手游排行榜-极上红颜手游下载-极上红颜游戏版本大全