1200行代码逆袭!DeepSeek工程师开源轻量级vLLM,吞吐量逼近原版

机器之心编辑部熟悉开源社区的朋友对 vLLM 应该不会陌生。它是由加州大学伯克利分校团队打造的

机器之心编辑部

熟悉开源社区的朋友对 vLLM 应该不会陌生。它是由加州大学伯克利分校团队打造的高性能、开源 LLM 推理和服务引擎,主要目标是提升大语言模型(LLM)的推理速度(吞吐量)和资源利用率(尤其是内存),并且兼容 Hugging Face 等主流模型库。

简而言之,vLLM 可以让 GPT、Mistral、LLaMA 等主流模型系列运行得更快且占用更少资源,而实现这一效果的核心技术就是其创新性的注意力机制方案——PagedAttention。

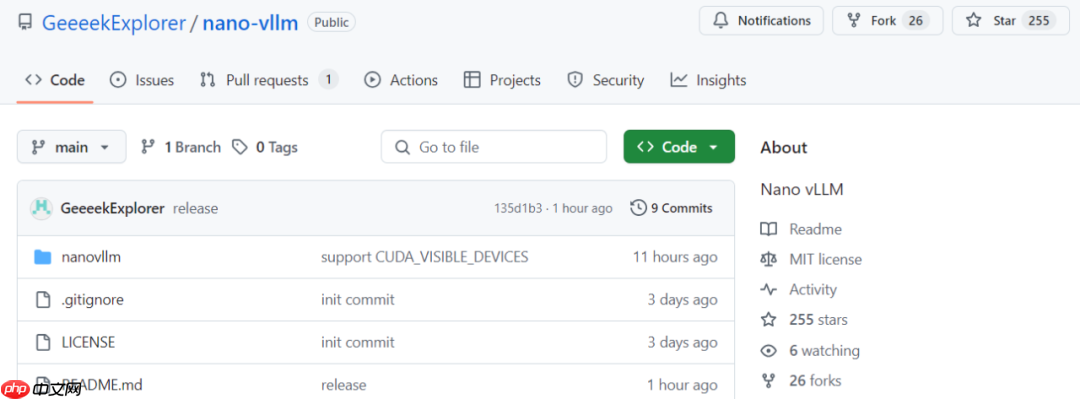

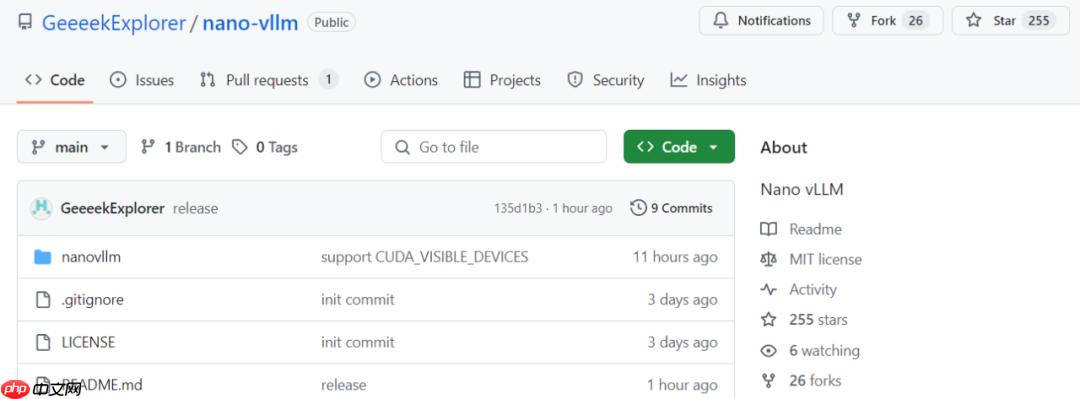

近日,来自 DeepSeek 的 AI 研究员、深度学习系统工程师俞星凯从零开始构建了一个极简版本的 vLLM 实现——Nano-vLLM,将整个项目代码压缩到了仅 1200 行以内。

目前该项目已在 GitHub 上获得超过 200 颗 Star。

图片GitHub 地址:https://www.php.cn/link/b3f2a6b3e119aaa5a1326802e7b49403

图片GitHub 地址:https://www.php.cn/link/b3f2a6b3e119aaa5a1326802e7b49403

具体来看,Nano-vLLM 具备以下三大核心特点:

第一,具备高效的离线推理能力,推理速度与原版 vLLM 相当。

第二,代码结构简洁易读,Python 总行数控制在了 1200 行以内。

第三,集成了多项优化工具,如 Prefix 缓存、Torch 编译以及 CUDA 计算图等特性。

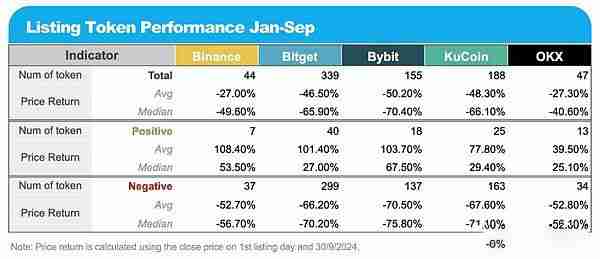

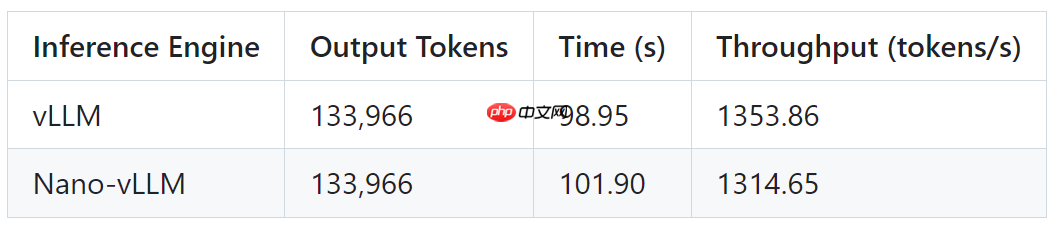

俞星凯在进行基准测试时使用了如下配置:

硬件:RTX 4070模型:Qwen3-0.6B总请求数:256 个序列输入长度:100–1024 tokens 范围内随机输出长度:100–1024 tokens 范围内随机测试结果如下表所示,Nano-vLLM 与 vLLM 输出 token 完全一致,响应时间略高,推理速度(吞吐量)稍有差距,但整体表现非常接近。

图片开发者简介

图片开发者简介

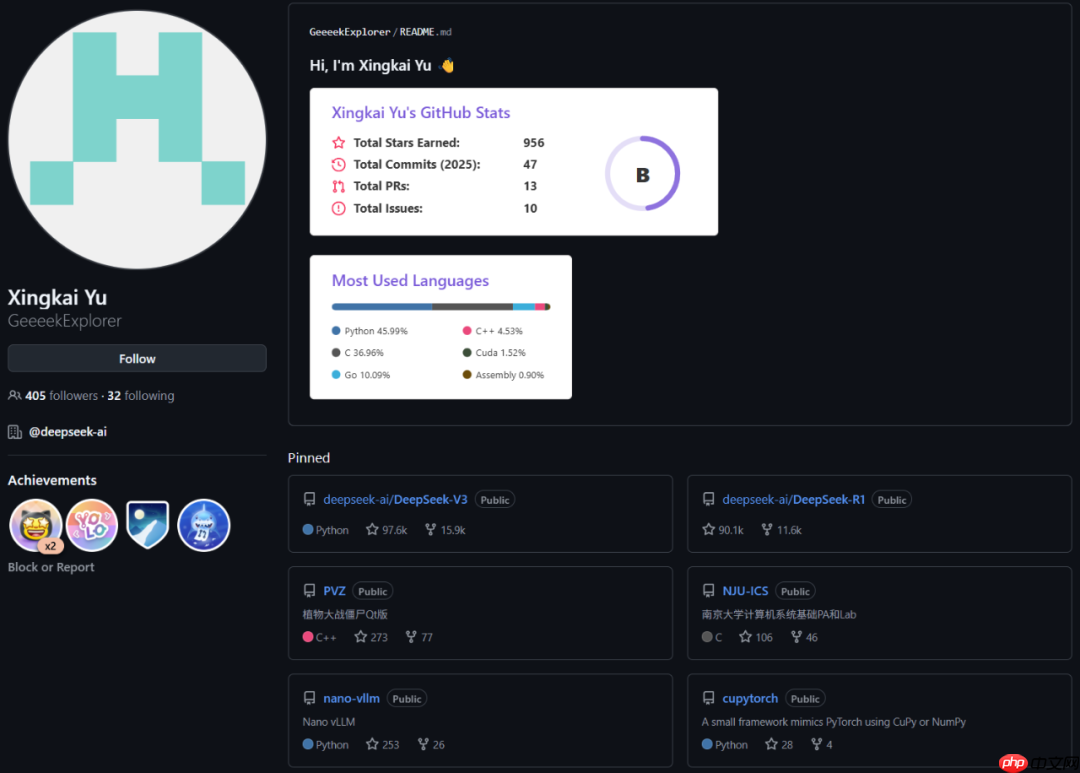

Nano-vLLM 的作者俞星凯目前任职于 DeepSeek,曾参与 DeepSeek-V3 和 DeepSeek-R1 的研发工作。

图片值得一提的是,根据其 GitHub 主页显示,他还开发过一个植物大战僵尸 Qt 版本,该项目也已获得 270 多颗 Star。此外,由于本科就读于南京大学,他还参与了不少南大的计算机相关项目,包括南京大学计算机图形学绘图系统、南京大学分布式系统 Raft 算法最简实现、南京大学操作系统 OSLab 等。

图片值得一提的是,根据其 GitHub 主页显示,他还开发过一个植物大战僵尸 Qt 版本,该项目也已获得 270 多颗 Star。此外,由于本科就读于南京大学,他还参与了不少南大的计算机相关项目,包括南京大学计算机图形学绘图系统、南京大学分布式系统 Raft 算法最简实现、南京大学操作系统 OSLab 等。

根据其 LinkedIn 页面信息显示,他曾先后在腾讯、幻方(DeepSeek 母公司)和字节跳动实习,并于 2023 年正式加入 DeepSeek 成为一名深度学习系统工程师。

图片你是 vLLM 用户吗?你会考虑尝试 Nano-vLLM 吗?

图片你是 vLLM 用户吗?你会考虑尝试 Nano-vLLM 吗?

© THE END

转载请联系本公众号获取授权

菜鸟下载发布此文仅为传递信息,不代表菜鸟下载认同其观点或证实其描述。

相关文章

更多>>热门游戏

更多>>热点资讯

更多>>热门排行

更多>>- 玛雅盛世题材手游排行榜下载-有哪些好玩的玛雅盛世题材手机游戏推荐

- 烈焰噬神ios手游排行榜-烈焰噬神手游大全-有什么类似烈焰噬神的手游

- 召唤三国ios手游排行榜-召唤三国手游大全-有什么类似召唤三国的手游

- 最强猎手排行榜下载大全-2023最好玩的最强猎手前十名推荐

- 血饮荣耀系列版本排行-血饮荣耀系列游戏有哪些版本-血饮荣耀系列游戏破解版

- 末世之手游戏排行-末世之手所有版本-末世之手游戏合集

- 神射传奇排行榜下载大全-2023最好玩的神射传奇前十名推荐

- 仙剑御天题材手游排行榜下载-有哪些好玩的仙剑御天题材手机游戏推荐

- 庆余江湖游戏排行-庆余江湖所有版本-庆余江湖游戏合集

- 三国少帝游戏排行-三国少帝所有版本-三国少帝游戏合集

- 2023冰雪屠龙手游排行榜-冰雪屠龙手游2023排行榜前十名下载

- 纵剑江湖手游2023排行榜前十名下载_好玩的纵剑江湖手游大全