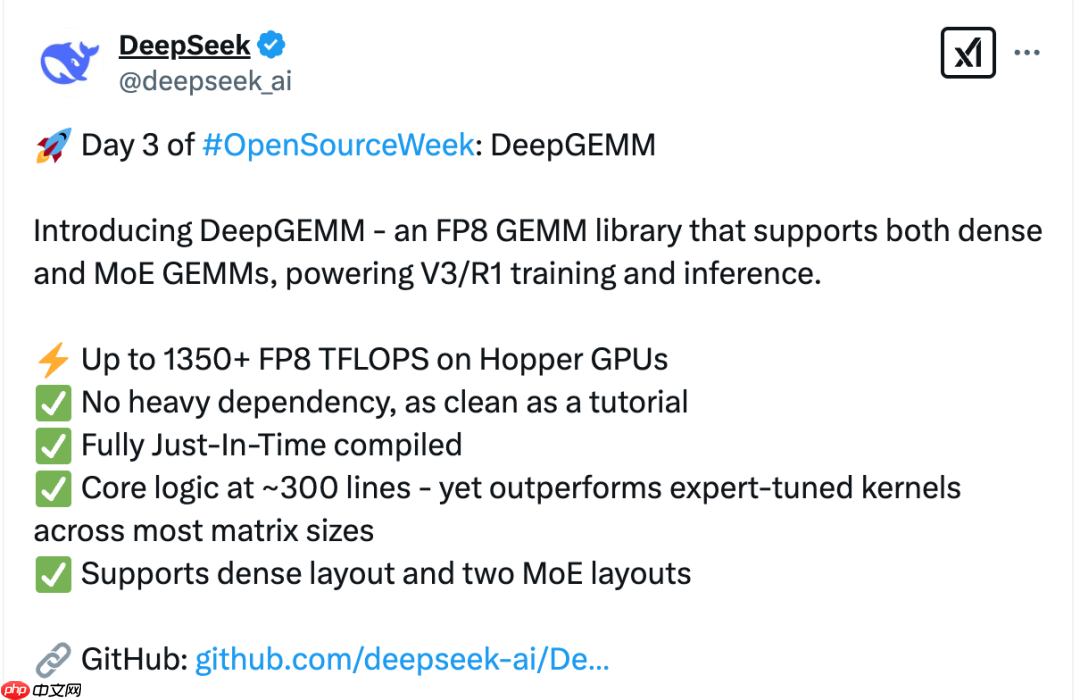

DeepSeek 开源周第三弹:DeepGEMM —— 高效的 FP8 GEMM 库,核心代码仅 300 行!

2025 年 2 月 26 日,在开源周的第三天,deepseek 正式推出了其高效的 fp8 通用矩阵乘法

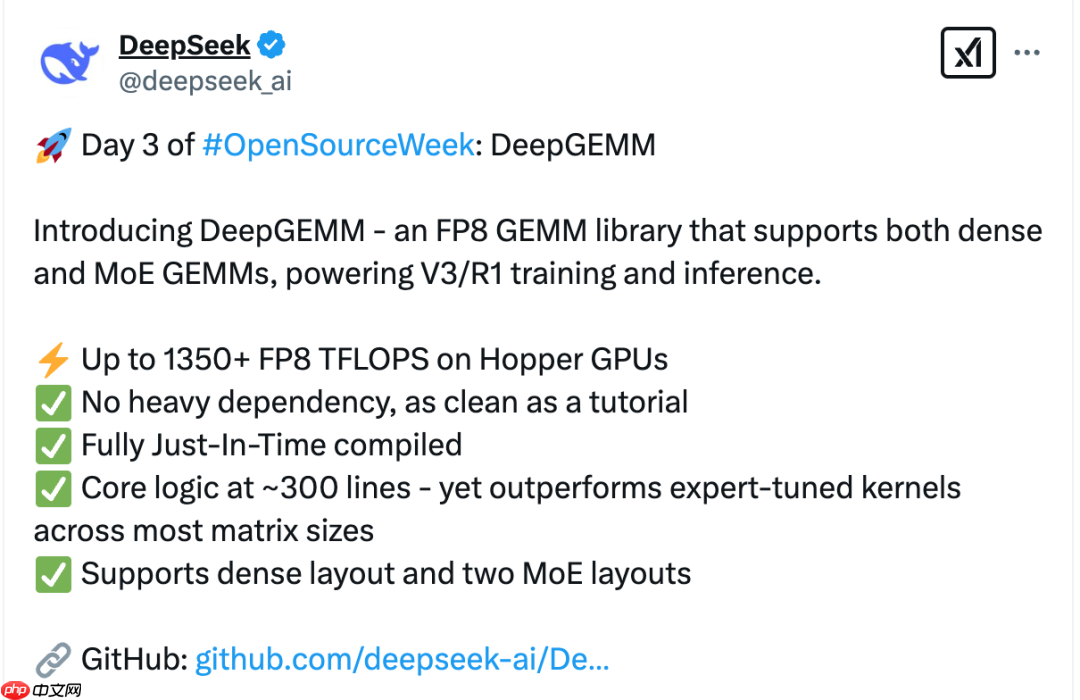

2025 年 2 月 26 日,在开源周的第三天,deepseek 正式推出了其高效的 fp8 通用矩阵乘法(gemm)库 —— deepgemm。该库不仅支持密集矩阵运算,还兼容混合专家(moe)架构的 gemm 操作,为 v3/r1 模型的训练与推理提供了强大助力。尤为引人注目的是,deepgemm 的核心代码仅约 300 行,却展现出卓越的性能表现。

为何需要 DeepGEMM?在大规模模型的训练与推理中,矩阵乘法(GEMM,General Matrix Multiplications)是最关键的计算操作之一,尤其在深度学习过程中占据了大量计算资源。随着模型规模的不断扩展,特别是混合专家模型(MoE)的广泛应用,传统 GEMM 实现已难以满足高效计算的需求。MoE 模型通过动态激活部分专家来提升模型容量,但也带来了稀疏性和动态性的问题,使传统的密集矩阵乘法难以高效处理。

此外,低精度计算(如 FP8)在深度学习中的应用日益广泛,因其能够在降低内存消耗的同时维持较高的计算效率。然而,现有 GEMM 库对 FP8 的支持仍较为有限,特别是在 MoE 场景下,缺乏专门优化。DeepGEMM 的推出正是为了应对上述挑战,它实现了高效的 FP8 矩阵乘法,并同时支持密集和 MoE 两种模式,显著提升了大模型训练与推理的效率。

DeepGEMM 的主要特点

- 高性能:在 NVIDIA Hopper GPU 上,DeepGEMM 的 FP8 计算性能超过 1350 TFLOPS,内存带宽峰值达到 2668 GB/s。

- FP8 支持:作为首个专为 Hopper GPU 优化的 FP8 GEMM 库,DeepGEMM 能够有效减少内存占用并加速模型训练与推理过程。

- 简洁而强大的实现:尽管核心代码仅约 300 行,但其性能超越了许多专家级优化内核,这得益于团队在算法设计上的精妙构思及对 GPU 架构特性的深入理解。

- 即时编译(JIT):采用轻量级 JIT 模块,可根据硬件配置和输入尺寸在运行时动态生成高度优化的代码,从而进一步提升性能。

- 支持密集与 MoE GEMM:不仅适用于传统密集矩阵乘法,还特别针对 MoE 模型中的 GEMM 运算进行了优化,满足多样化的模型计算需求。

DeepGEMM 的性能表现

DeepSeek 团队在 H800 GPU 上使用 NVCC 12.8 对 DeepGEMM 进行了全面测试,涵盖了 DeepSeek-V3/R1 推理中可能涉及的各种矩阵形状(包括预填充和解码阶段,但不包含张量并行)。测试结果表明,DeepGEMM 的计算性能最高可达 1358 TFLOPS,内存带宽峰值达 2668 GB/s。相比基于 CUTLASS 3.6 的优化实现,性能提升幅度最高达 2.7 倍;在 MoE 模型下的分组 GEMM(连续性布局和掩码布局)中,性能提升也超过 1.2 倍。

总结

DeepGEMM 的发布标志着 DeepSeek 在高效矩阵乘法计算领域取得了又一重要突破。该库不仅支持 FP8 低精度计算,还对 MoE 模型进行了深度优化,大幅提升了大模型训练与推理的效率。未来,DeepSeek 还将带来哪些令人期待的开源项目?让我们共同关注其在开源道路上的更多精彩表现。

参考资料deepseek-ai/DeepGEMM:https://www.php.cn/link/e0c082bdcbcf050ff454698580c89289

菜鸟下载发布此文仅为传递信息,不代表菜鸟下载认同其观点或证实其描述。

相关文章

更多>>热门游戏

更多>>热点资讯

更多>>热门排行

更多>>- 龙泣仙缘系列版本排行-龙泣仙缘系列游戏有哪些版本-龙泣仙缘系列游戏破解版

- 类似龙卫传奇的手游排行榜下载-有哪些好玩的类似龙卫传奇的手机游戏排行榜

- 云舞风华游戏排行-云舞风华所有版本-云舞风华游戏合集

- 永燃之焰题材手游排行榜下载-有哪些好玩的永燃之焰题材手机游戏推荐

- 多种热门耐玩的冰火西游破解版游戏下载排行榜-冰火西游破解版下载大全

- 类似星辰天下的游戏排行榜_有哪些类似星辰天下的游戏

- 类似幻灵天命的手游排行榜下载-有哪些好玩的类似幻灵天命的手机游戏排行榜

- 剑虚破风ios手游排行榜-剑虚破风手游大全-有什么类似剑虚破风的手游

- 信条刺客排行榜下载大全-2023最好玩的信条刺客前十名推荐

- 龙之沙漠系列版本排行-龙之沙漠系列游戏有哪些版本-龙之沙漠系列游戏破解版

- 2023明月传说手游排行榜-明月传说手游2023排行榜前十名下载

- 决战盛世游戏排行-决战盛世所有版本-决战盛世游戏合集