2025 年 2 月 24 日,中国人工智能明星企业 deepseek 正式拉开“开源周”序幕,并率先推

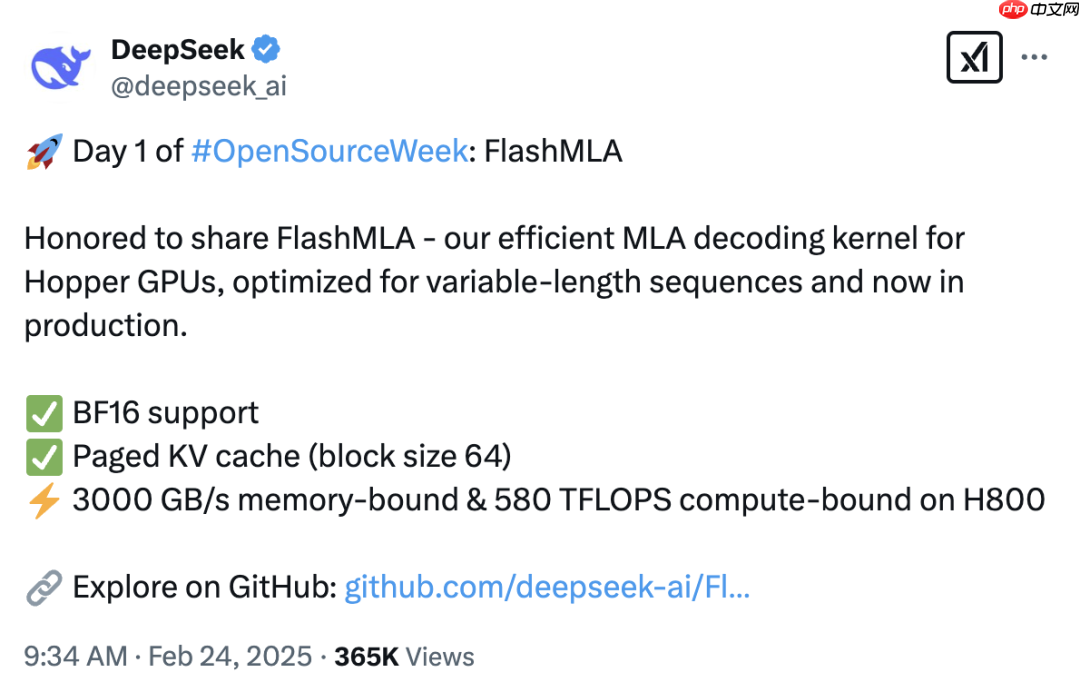

2025 年 2 月 24 日,中国人工智能明星企业 deepseek 正式拉开“开源周”序幕,并率先推出重磅技术成果 —— flashmla。这款专为 nvidia hopper gpu 设计的高性能解码内核,深度优化了多头潜注意力(mla)机制,在处理变长序列的大语言模型(llm)推理任务中展现出卓越性能。

FlashMLA 是什么?

FlashMLA 是 DeepSeek 专为 Hopper 架构 GPU(如 H100/H800)打造的 MLA 解码内核。其核心目标是通过动态内存调度与并行计算优化,显著提升大语言模型在处理可变长度序列时的推理效率。

FlashMLA 的性能表现如何?

在 H800 SXM5 GPU 上,基于 CUDA 12.6 的测试数据显示:

- 内存受限场景下:传输速度高达 3000 GB/s。

- 计算受限场景下:算力可达 580 TFLOPS。

FlashMLA 的工作原理

在自然语言处理和生成式 AI 等任务中,输入数据通常具有不规则的长度,这对传统解码器构成挑战。FlashMLA 利用 Hopper GPU 的架构优势,优化内存使用与计算流程,确保无论输入长度如何变化,都能实现高效稳定的性能输出。

其关键创新包括对 BF16 格式的支持以及采用块大小为 64 的分页 KV 缓存机制,这些设计有效降低了内存开销和延迟,使其成为实时 AI 应用的理想选择。开发者将因此获得更快速的模型训练与推理体验,尤其适用于复杂且动态的数据集。

此外,FlashMLA 还融合了 FlashAttention 2&3 和 CUTLASS 等项目的最佳实践,进一步提升了整体性能与兼容性。

FlashMLA 的主要优势

针对 Hopper GPU 的极致优化借助 NVIDIA Hopper 架构的 Tensor Cores 和 Transformer Engines,FlashMLA 实现了 3000 GB/s 的内存带宽与 580 TFLOPS 的计算能力,轻松应对 LLM 的高负载运算需求。

支持变长序列处理特别适合 NLP 场景,能够灵活适应各种输入长度,广泛应用于聊天机器人、翻译系统及文本生成等实际场景。

高效的内存管理机制分页 KV 缓存设计(块大小为 64)提升了内存利用率,减少了推理延迟,特别适用于内存受限的大型模型。

BF16 精度优化支持 BF16 数据格式,在保证精度的同时降低内存占用,加快计算速度,更适合资源受限环境下的模型部署或扩展。

支持超大规模模型推理通过优化数据流动和内存访问,FlashMLA 可运行超出 GPU 显存容量两倍的模型,相比 CPU 提速 4-5 倍,GPU 上提速达 20-25 倍,无需昂贵硬件即可支撑超大模型运行。

FlashMLA 对 AI 发展的意义

在 2025 年初,随着 xAI 推出 Grok 语音模式,实时交互式 AI 成为新焦点。FlashMLA 的推出正好强化了后端基础设施,满足日益增长的 AI 模型对速度与效率的需求。

医疗、金融等行业将从中受益。例如,实时患者数据分析或高频交易决策等场景,均可借助 FlashMLA 实现毫秒级响应,推动行业智能化升级。

同时,DeepSeek 的开源策略也有助于 AI 领域的公平竞争与透明发展,使得更多中小团队也能参与前沿模型的研发与应用。

总结

FlashMLA 的发布只是 DeepSeek 开源周的第一步。未来或将推出面向其他 GPU 架构的优化版本、增强 BF16 支持,以及与主流 AI 框架的深度集成。接下来还有哪些技术亮点?值得持续关注。

参考资料deepseek-ai/FlashMLA:https://www.php.cn/link/a588b762d68fe60225d3de3c647a52b9

菜鸟下载发布此文仅为传递信息,不代表菜鸟下载认同其观点或证实其描述。

相关文章

更多>>热门游戏

更多>>热点资讯

更多>>热门排行

更多>>- 地藏诛魔系列版本排行-地藏诛魔系列游戏有哪些版本-地藏诛魔系列游戏破解版

- 多种热门耐玩的药神火龙破解版游戏下载排行榜-药神火龙破解版下载大全

- 怒炎沙城题材手游排行榜下载-有哪些好玩的怒炎沙城题材手机游戏推荐

- 灵剑之刃题材手游排行榜下载-有哪些好玩的灵剑之刃题材手机游戏推荐

- 风掠大秦ios手游排行榜-风掠大秦手游大全-有什么类似风掠大秦的手游

- 元气神姬题材手游排行榜下载-有哪些好玩的元气神姬题材手机游戏推荐

- 庆余江湖排行榜下载大全-2023最好玩的庆余江湖前十名推荐

- 天雷滚滚系列版本排行-天雷滚滚系列游戏有哪些版本-天雷滚滚系列游戏破解版

- 烈焰噬神最新排行榜-烈焰噬神手游免费版下载-烈焰噬神免费破解版下载

- 多种热门耐玩的苍穹冰雪破解版游戏下载排行榜-苍穹冰雪破解版下载大全

- 武林战争手游2023排行榜前十名下载_好玩的武林战争手游大全

- 纪末妖仙题材手游排行榜下载-有哪些好玩的纪末妖仙题材手机游戏推荐