650亿参数大模型预训练方案开源可商用!LLaMA训练加速38%,来自明星开源项目

明敏 发自 凹非寺量子位 | 公众号 qbitai650亿参数大模型的预训练方案一经发布便开源,训练

明敏 发自 凹非寺量子位 | 公众号 qbitai

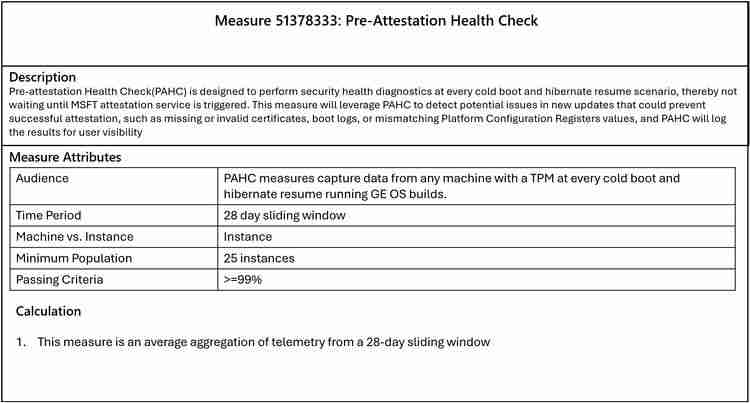

650亿参数大模型的预训练方案一经发布便开源,训练速度较传统方案提升了38%。这就是由Colossal-AI最新推出的类LLaMA基础大模型预训练方案。

在“百模大战”的背景下,拥有自家大模型被视为核心竞争力。在这个关键时刻,愿意开源大模型的公司寥寥无几。然而,从头训练一个大模型对技术和资金要求极高。因此,Colossal-AI的最新开源举措可谓是顺应了当前形势的需求。而且它还允许商业使用,仅需4步即可开箱即用。

在“百模大战”的背景下,拥有自家大模型被视为核心竞争力。在这个关键时刻,愿意开源大模型的公司寥寥无几。然而,从头训练一个大模型对技术和资金要求极高。因此,Colossal-AI的最新开源举措可谓是顺应了当前形势的需求。而且它还允许商业使用,仅需4步即可开箱即用。

具体项目内容如下,请继续阅读:

开源地址:https://www.php.cn/link/b9531e7d2a8f38fe8dcc73f58cae9530

仅需32张A100/A800即可使用。自从Meta开源LLaMA以来,掀起了一波微调项目的热潮,如Alpaca、Vicuna、ColossalChat等都是基于此构建的。

然而,LLaMA只开源了模型权重且限制商业使用,微调能够提升和注入的知识与能力也相对有限。对于真正希望投身大模型浪潮的企业来说,训练自己的核心大模型至关重要。

然而,LLaMA只开源了模型权重且限制商业使用,微调能够提升和注入的知识与能力也相对有限。对于真正希望投身大模型浪潮的企业来说,训练自己的核心大模型至关重要。

开源社区此前已推出了一系列工作:

RedPajama:开源可商用类LLaMA数据集(无训练代码和模型)OpenLLaMA:开源可商用类LLaMA 7B/13B模型,使用EasyLM基于JAX和TPU训练Falcon:开源可商用类LLaMA 7B/40B模型(无训练代码)但这些还不够,因为对于最主流的PyTorch+GPU生态,仍缺乏高效、可靠、易用的类LLaMA基础大模型预训练方案。

因此,Colossal-AI交出了最新的开源答案。

仅需32张A100/A800,即可完成650亿参数类LLaMA大模型预训练,训练速度提升38%。

而像原生PyTorch、FSDP等,则因显存溢出无法运行该任务。Hugging Face accelerate、DeepSpeed、Megatron-LM也未对LLaMA预训练进行官方支持。

而像原生PyTorch、FSDP等,则因显存溢出无法运行该任务。Hugging Face accelerate、DeepSpeed、Megatron-LM也未对LLaMA预训练进行官方支持。

项目上手非常简单,只需四步:

1、安装Colossal-AI2、安装其他依赖项3、数据集4、运行命令具体代码如下:

第一步、安装Colossal-AI。

代码语言:javascript代码运行次数:0运行复制```javascriptgit clone -b example/llama https://www.php.cn/link/b9531e7d2a8f38fe8dcc73f58cae9530.gitcd ColossalAI# install and enable CUDA kernel fusionCUDA_EXT=1 pip install .

第二步、安装其他依赖项。登录后复制代码语言:javascript代码运行次数:0运行复制javascript cd examples/language/llama# install other dependenciespip install -r requirements.txt# use flash attentionpip install xformers

菜鸟下载发布此文仅为传递信息,不代表菜鸟下载认同其观点或证实其描述。

相关文章

更多>>热门游戏

更多>>热点资讯

更多>>热门排行

更多>>- 阴阳双剑游戏版本排行榜-阴阳双剑游戏合集-2023阴阳双剑游戏版本推荐

- 2023大道惊仙手游排行榜-大道惊仙手游2023排行榜前十名下载

- 九天伏魔游戏版本排行榜-九天伏魔游戏合集-2023九天伏魔游戏版本推荐

- 武动九天手游排行-武动九天免费版/单机版/破解版-武动九天版本大全

- 类似傲剑情缘的手游排行榜下载-有哪些好玩的类似傲剑情缘的手机游戏排行榜

- 卓越之翼系列版本排行-卓越之翼系列游戏有哪些版本-卓越之翼系列游戏破解版

- 多种热门耐玩的勇者神途破解版游戏下载排行榜-勇者神途破解版下载大全

- 青云诀2游戏排行-青云诀2所有版本-青云诀2游戏合集

- 梦幻战歌题材手游排行榜下载-有哪些好玩的梦幻战歌题材手机游戏推荐

- 类似仙灵九歌的游戏排行榜_有哪些类似仙灵九歌的游戏

- 类似一剑之缘的手游排行榜下载-有哪些好玩的类似一剑之缘的手机游戏排行榜

- 鲲神世界排行榜下载大全-2023最好玩的鲲神世界前十名推荐